Blaubeermuffins oder Chihuahuas: Warum sich die Linke mit künstlicher Intelligenz beschäftigen sollte

Twitter/@teenybiscuit

Twitter/@teenybiscuitWenn es um die plattformkapitalistische Verwertungsmaschinerie geht, wenn es um Überwachung von digitaler Arbeit, KundInnen und NutzerInnen geht und um die Zukunft beziehungsweise Prekarisierung der Arbeit – in allen diesen drei zentralen Fragen des digitalen Kapitalismus spielen KI-Technologien eine wichtige Rolle. Ein Beitrag aus dem OXI-Schwerpunkt der Oktoberausgabe »Linke und Technik«.

Künstliche Intelligenz ist das Modethema der Stunde. Die Technologie ist gereift und wird vom digitalen Kapitalismus eingesetzt, um sein plattformkapitalistisches Verwertungsmodell zu konsolidieren. Daher sollte sich auch die Linke unbedingt mit ihr beschäftigen.

Erstens: ein Bilderwettbewerb

Zuverlässige Bilderkennung ist eine der wichtigsten Aufgaben für lernende Software (maschinelles Lernen), die meist gemeint ist, wenn derzeit von künstlicher Intelligenz die Rede ist: Blaubeermuffins von Chihuahuas zu unterscheiden ist auch für Menschen oft eine knifflige Angelegenheit.

Als Gradmesser der Fortschritte auf diesem Gebiet kann die seit 2010 jährlich veranstaltete ImageNet Challenge gelten, bei der es um die Identifizierung von Objekten in digitalen Bildern geht. Hochkarätige Teams streiten darum, welche Algorithmen dabei die niedrigste Fehlerquote erzielen.

Im Jahre 2012 konnte das Gewinnerteam dank des Einsatzes von maschinellem Lernen die Fehlerquote von bis dato üblichen 30 Prozent auf unter 15 Prozent drücken. Daraufhin übernahmen alle Teams diese Technik, seit 2015 liegt die Fehlerquote der besten Teams bereits bei 2 bis 3 Prozent, seit 2017 schaffen es die meisten aller 38 teilnehmenden Teams, unter 5 Prozent zu bleiben.

Bei solchen Anwendungen kann eine Fehlerquote im niedrigen Prozentbereich als Ausnahme oder Ausreißer gewertet werden und ist durchaus tolerabel. Entscheidend ist jedoch die Tatsache, dass die durchschnittliche Fehlerquote einer menschlichen Vergleichsgruppe etwa bei 5 Prozent liegt: Die maschinelle Bilderkennung ist zuverlässig exakter als der Mensch geworden, die Anwendung im Massenmarkt steht offen.

Zweitens: »Künstliche Intelligenz« – Warum jetzt?

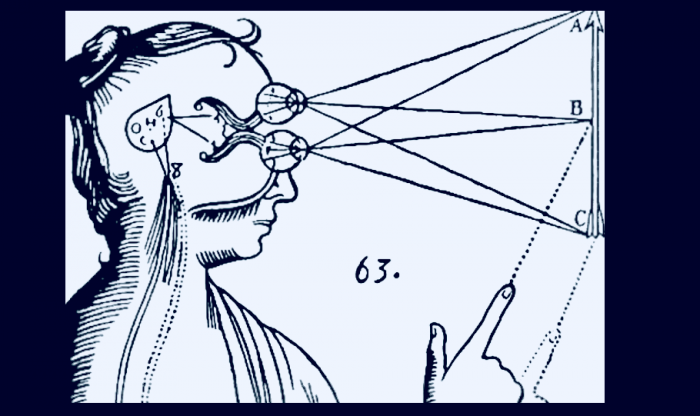

Wenn heute von künstlicher Intelligenz die Rede ist, dann in den allermeisten Fällen von einem Teilbereich, der sich mit maschinellem Lernen überschreiben lässt – dem Oberbegriff für Verfahren, die es Maschinen ermöglichen, Wissen aus Erfahrung zu generieren, sprich: zu lernen. Im Gegensatz zur klassischen KI, die versucht, denkende Maschinen zu bauen, geht es hier um deutlich profanere Dinge: um Software, die Personen oder Gegenstände auf Bildern erkennen kann, menschliche Sprache analysieren und adäquat darauf reagieren kann und dergleichen.

»Deep Learning« wiederum ist ein Teilbereich des maschinellen Lernens, es arbeitet mit künstlichen neuronalen Netzen, die dem menschlichen Gehirn nachempfunden sind, um zu besonders effizienten Lernerfolgen zu gelangen. Ziel neuronaler Netze ist es, Strukturen zu erkennen in den Daten, mit denen das System gefüttert wird (Input), diese zu evaluieren und in vielen Durchläufen selbstständig die Ergebnisse (Output) zu verbessern.

»Deep Learning« setzt auf statistische Datenanalyse und nicht auf einen deterministischen Algorithmus, wir haben es also mit einer Verschiebung weg von der Lösung von reinen Programmieraufgaben hin zu datengetriebener Optimierung zu tun. Der erste Ansatz schlägt insbesondere fehl, wenn die Regeln, die implementiert werden sollen, gar nicht im Detail bekannt sind.

Ein Beispiel: Für das autonome Fahren wird nicht versucht, ein für alle Mal das perfekte Programm mit vielen Millionen Zeilen Code zu schreiben. Sondern es geht darum, für bestimmte Situationen einen Lernprozess in Gang zu setzen. Deshalb werden die gefahrenen Testkilometer im Simulator – das entspricht den Input-Daten in neuronalen Netzen – zum Hauptkriterium des Erfolgs.

Maschinelles Lernen wird immer besser und verbreiteter und schließlich auch zum ökonomischen Faktor. So werden 80 Prozent aller Inhalte auf der Online-Streaming-Plattform Netflix, die in 190 Ländern Geschäfte macht, den Nutzerinnen und Nutzern vorher empfohlen.

Wie schafft Netflix diese beeindruckende Quote – diese Zahl bedeutet schließlich, dass der Streaming-Dienst in vier von fünf Fällen voraussagen kann, was wir sehen werden, noch bevor wir es selbst wissen? Zum einen klassifiziert Netflix die Inhalte nach 2.000 Kategorien, zum anderen werden anhand vieler Parameter die Sehgewohnheiten von 250 Millionen Accounts beobachtet. Diese Unmenge an Daten wird in Echtzeit eingespeist in einen selbstlernenden Algorithmus – heraus kommen die Empfehlungen als Output.

Drittens: KI und der digitale Kapitalismus

Die Großen der KI sind übrigens die gleichen Unternehmen, die die digital-kapitalistische Plattformökonomie beherrschen: Alphabet, Amazon, Facebook, Google, IBM, Microsoft und noch ein paar andere wie Apple, Tesla oder der Chip-Hersteller Nvidia – nicht zu vergessen: ihre chinesischen Pendants Alibaba, Tencent und Baidu.

Das ist auch kein Zufall, denn bei der heutigen KI, bei der es darum geht, mit vielen Daten Algorithmen zu trainieren, steht die Menge und Qualität der Trainingsdaten im Vordergrund, und nicht mehr Menge oder Qualität des Codes. Wer also über viele Daten verfügt, erlangt einen strategischen Vorteil. Und Technologien maschinellen Lernens sind geradezu ideal geeignet, in Datenozeanen Strukturen zu erkennen, Modelle zu entwickeln, und daraus wiederum Vorhersagen zu generieren.

Plattformen (der englische Begriff platform kommt aus der Software-Entwicklung und bezeichnet dort eine Grund-Technologie, auf der dann bestimmte Dienste aufbauen) sind proprietäre, also die Möglichkeiten der Wieder- und Weiterverwendung stark einschränkende Anwendungen oder Online-Angebote, die meist kostenlos eine Dienstleistung anbieten. Durch den Netzwerkeffekt, bei dem der Nutzen eines Gutes mit steigender NutzerInnen-Zahl zunimmt, erzielen sie rasch eine Monopolstellung. Plattformen verwerten die Aktivität ihrer User, die – halb ArbeiterIn, halb KundIn – für die Generierung der Daten verantwortlich zeichnen.

Was ist eigentlich Big Data? Wenn eine Kommune wissen will, wie hoch das Verkehrsaufkommen an einer bestimmten Kreuzung ist, kann sie ein paar Leute abstellen, die an der Kreuzung beobachtend ein paar Tage lang eine Strichliste führen. Im Anschluss können aus dieser – begrenzten und mit viel Aufwand erstellten – Stichprobe Schlussfolgerungen gezogen werden. Das könnte man Small Data nennen.

Ganz anders bei einer digitalen Taxi-Plattform: Sie bekommt präzise Bewegungsdaten nicht von einigen wenigen, sondern von allen vermittelten Fahrten, KundInnen und Fahrzeugen. Zudem fallen diese Daten ganz automatisch an, ohne Mehraufwand und ohne Verzögerung: Sie liegen bereits in digitaler Form vor und können in Echtzeit von Algorithmen ausgewertet werden und zum Beispiel KundInnen und FahrerInnen einander zuweisen. Das ist Big Data.

Aus zwei Gründen haben wir es gerade mit einer Renaissance der Disziplin zu tun: Die KI, um die es heute geht, funktioniert mittlerweile sehr gut, dank jahrzehntelanger Vorarbeiten und insbesondere Fortschritten in der Rechenleistung. Und zweitens gibt es in vielen Bereichen immense Datenmengen, die als Trainingsdaten verwendet werden können.

Heraus kommen kapitalistisch verwertbare Anwendungsfelder, mit denen viel Geld verdient werden kann – so jedenfalls die Hoffnung der Großen der Branche. Als Google 2014 Deep Mind kaufte, wunderten sich noch viele – heute ist deren Know-how in den Kern der Geldmaschine vorgedrungen.

Viertens: KI ist schön, macht aber auch viel Arbeit

Neben Drohbildern wie der Übernahme der Weltherrschaft und dem Auslösen des Dritten Weltkriegs ist die Vorstellung, KI und Roboter führten zu Massenarbeitslosigkeit, wohl am weitesten verbreitet. Ob Roboter und KI Arbeitsplätze vernichten, scheint immer die große Frage zu sein, die insbesondere die Arbeiterbewegungs-Linke umtreibt. Die Angst vor dem Verlust des Arbeitsplatzes beziehungsweise davor, dass jene, die ihn verlieren, die AfD wählen, treibt nicht nur den Brandenburgischen Ministerpräsidenten Dietmar Woidke von der SPD um, sondern auch weite Teile der Linken.

Verblüffend, dass das digitale Kapital selbst es ist, das diesen Trend befeuert. Dabei dürfte die historische Tendenz klar sein: Das Kapital schafft die Lohnarbeit zusehends selbst ab, Volkswagen versucht seine ArbeiterInnen schon mit 55 in Rente zu schicken, um sie durch Roboter zu ersetzen. Auch wenn noch ein paar Jahre länger gebaggert werden wird im Braunkohletagebau, auch wenn noch ein paar Jahre länger Diesel-Fahrzeuge von Hand montiert werden, der historische Trend ist klar: Die Ära der proletarischen Arbeit geht zu Ende. Und KI ist dabei nur ein Faktor unter vielen.

In der Zwischenzeit findet eine Verschiebung statt, in dem Maße, in dem das Projekt die Fabrik als Paradigma kapitalistischer Organisation ablöst, wird die klassische Lohnarbeit zu temporärer, projektorientierter, prekärer Beschäftigung transformiert. In den letzten 10 Jahren sind 94 Prozent aller neu entstandenen Arbeitsplätze außerhalb traditioneller Beschäftigungsformen entstanden. Bereits etwa ein Drittel der Beschäftigten und die Hälfte der jungen Beschäftigten sind Teil eines befristeten und tendenziell prekären neuen Arbeitsmarkts.

Bevor in naher Zukunft etwa autonom fahrende Lastwagen Millionen FernfahrerInnen um Lohn und Brot bringen werden, ist jedoch noch viel Fleißarbeit nötig. Was Karl Valentin über die Kunst sagte, stimmt auch für die KI: Sie ist schön, macht aber viel Arbeit. Künstliche Intelligenz benötigt eine Menge Trainingsdaten und viele DatenwissenschaftlerInnen, die diese Prozesse überwachen und auswerten.

»Daten sammeln ist Handarbeit«, sagt Aljoscha Burchardt vom Deutschen Forschungsinstitut für Künstliche Intelligenz in Berlin. In allen Branchen sind KI-Anwendungen auf dem Vormarsch, selbst der VW-Konzern stellt Tausende IT-Fachkräfte ein, unter anderem DatenwissenschaftlerInnen. Insbesondere im globalen Süden finden sich immer mehr KlickworkerInnen vor Bildschirmen wieder, auf denen sie Bilder für KI sortieren, um diese zu trainieren. Und KI-Technologien sind ganz nebenbei perfekt geeignet, digitale Arbeit zu überwachen.

Neben KlickworkerInnen auf digitalen Arbeitsplattformen und DatenspezialistInnen bei den großen Unternehmen sind wir alle als NutzerInnen der Dienste der Digitalkonzerne dabei, KI zu trainieren: Wir produzieren Daten, zum Beispiel Sprachkommandos für Amazons Alexa, die als Input-Daten in die KI eingespeist werden – wir leisten also selbst einen Beitrag zur Optimierung der Services, die uns dann wieder in verbesserter Form gegenübertreten.

Die amerikanische Wissenschaftlerin Kate Crawford benennt eine Art hybriden Zustand, in dem sich BenutzerInnen von KI-Geräten wiederfinden, indem sie ein Produkt kaufen, für dessen Hersteller aber gleichzeitig eine Ressource darstellen: »Sie sind auch Arbeiter, die unbezahlte Arbeit leisten, indem sie dem System Feedback liefern.« Die Professorin an der New York University und Mitbegründerin des AI Now Institutes, das die sozialen Auswirkungen der Entwicklung künstlicher Intelligenz untersucht, betont das Neue daran: »Diese Kombination aus einem Verbraucher, einem Arbeiter, einer Ressource und einem Produkt ist etwas sehr Neues.«

Fünftens: Überwachungs-Kapitalismus

Der Siegeszug digitaler Geräte und Anwendungen hat die Art und Weise verändert, wie wir alltägliche Dinge erledigen. Immer öfter sind digitale Geräte und Applikationen sowie über das Internet vermittelte Transaktionen daran unmittelbar beteiligt. Auf der einen Seite stehen oft kostenlos eine Vielzahl an bequemen Services vermittelt über Smartphones und deren Anwendungen zur Verfügung. Vieles davon war vor wenigen Jahren undenkbar, sündhaft teuer oder nur dem Militär vorbehalten, etwa GPS, Kartenmaterial, Bilderkennung, Sprachsteuerung, ubiquitäre, also allgegenwärtige Internet-Verbindung et cetera.

Auf der anderen Seite ist Schluss mit Anonymität und Privatsphäre. Im Gegenzug für die Nutzung der Geräte und Anwendungen generieren wir wertvolle Daten für diese Unternehmen. »Fast jede Aktivität in unserer heutigen Gesellschaft bedingt das Hinterlassen von Spuren«, sagte Doug Klunder, der bei der Amerikanischen Bürgerrechtsunion American Civil Liberties Union für Datenschutz-Themen zuständig ist, bereits 2010.

Diese Verquickung von Überwachung, Datensammlung, Identifizierung in bisher unbekanntem Ausmaß mit dem Nutzen, Verfügbarkeit, die damit einhergehende Bequemlichkeit für die AnwenderInnen, gehört der Harvard-Professorin Shoshana Zuboff zufolge zum Kern des digitalen Kapitalismus. Sie seien untrennbar mit dessen Ideologie und Geschäftsmodellen verknüpft, sie spricht daher vom »Überwachungs-Kapitalismus«.

Bei Apples iPhone gibt es zum Beispiel die Funktion, eine Person auf einem Foto durch Tippen und Halten auszuwählen und daraufhin eine Diashow mit allen Fotos zu starten, die diese Person ebenfalls enthalten. Selbst auf zehn Jahre alten, unscharfen oder angeschnittenen Fotos – die Gesichtserkennung funktioniert erstaunlich gut.

Auch von Facebook kennt man die Funktion, Personen auf Bildern zu identifizieren. Die Bilder liegen dabei auf den Servern von Apple, die KI-Algorithmen sind mit Millionen solcher Bilder trainiert worden: Die Erfolge bei der Bilderkennung durch maschinelles Lernen sind in unserem Alltag angekommen.

Das ist nur ein Beispiel für Anwendungen, die auf lernenden Algorithmen beruhen und zur Alltagstechnologie geworden sind. Die digitalen Konzerne sind es, die allen voran diese Technologien beherrschen, einsetzen und auf die Konsolidierung ihrer Marktmacht hoffen. Techniken um künstliche Intelligenz sind also so etwas wie die Verarbeitungs- und Verwertungsmaschine eines auf »user generated content«, also von den NutzerInnen selbst erzeugten Inhalten basierenden plattformkapitalistischen Modells.

KI ist im Zentrum des gegenwärtigen Kapitalismus zu finden: Wenn es um die plattformkapitalistische Verwertungsmaschinerie geht, wenn es um Überwachung von digitaler Arbeit, KundInnen und NutzerInnen geht und um die Zukunft beziehungsweise Prekarisierung der Arbeit – in allen diesen drei zentralen Fragen des digitalen Kapitalismus spielen KI-Technologien eine wichtige Rolle.

Allein das sollte Grund genug sein, sich als gesellschaftliche Linke damit zu beschäftigen. Und in der Debatte um Alternativen jenseits der Verwertungslogik und verschiedenster Formen der fremdbestimmten Arbeit und die persönliche Freiheit bedrohenden Entwicklungen eine Kritik kapitalistischer künstlicher Intelligenz zu leisten – und vielleicht sogar vernünftige Alternativen zu entwickeln.

Timo Daum arbeitet als Hochschullehrer in den Bereichen Online, Medien und Digitale Ökonomie. Zuletzt erschien von ihm in der Edition Nautilus »Das Kapital sind wir. Zur Kritik der digitalen Ökonomie«, für das er den Preis »Das politische Buch« der Friedrich-Ebert-Stiftung 2018 erhielt. Im Frühjahr 2019 erscheint von ihm »Die künstliche Intelligenz des Kapitals« in der Edition Nautilus.

Guter Journalismus ist nicht umsonst…

Die Inhalte auf oxiblog.de sind grundsätzlich kostenlos. Aber auch wir brauchen finanzielle Ressourcen, um oxiblog.de mit journalistischen Inhalten zu füllen. Unterstützen Sie OXI und machen Sie unabhängigen, linken Wirtschaftsjournalismus möglich.

Zahlungsmethode